Bayesian Optimization|贝叶斯优化

贝叶斯优化

Hyperparameters 超参的调整是 Deep Learning 较为耗时的一部分。比起 grid search 耗时耗力的暴力破解与 random search 的若有缘则相见。贝叶斯优化提供了一种相对有方向的搜索方案。

算法大致思路

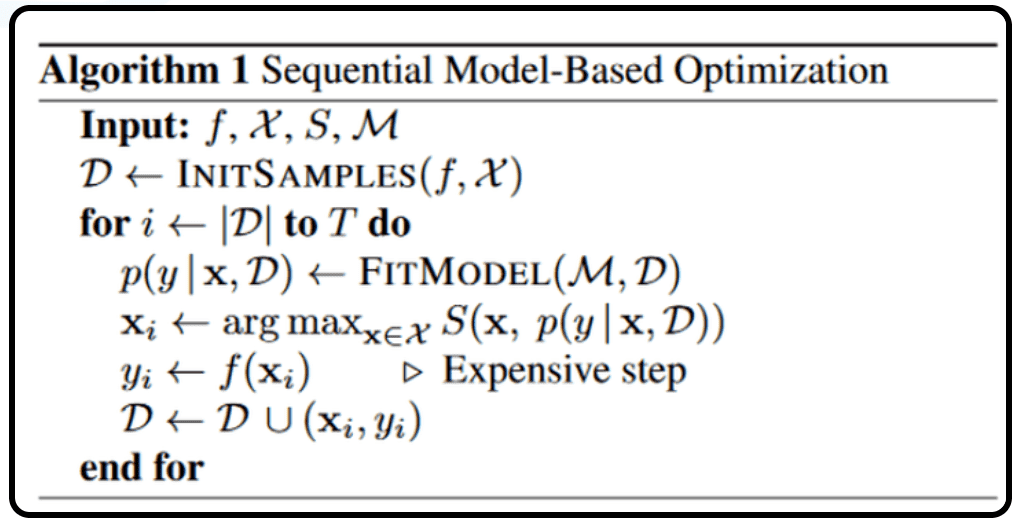

SMBO 算法的本质,是建立并不断完善 hyper parameters ()与 模型最优解 () 间关系的过程。这个算法的终止由人为决定,比如限制算法运行时间,设置目标值等。

SMBO 算法解释

在上述表格中 为我们想要求出其超参的模型

首先,选择几个超参方案 组成我们的超参集 ,并计算在这些超参组合下模型 可以达到的最优分数 。因此对于每一个超参方案都会映射到一个最优分数。这些映射的集合便是

而后我们对下面步邹迭代,直到达到目标条件:

- 给定 prior , 更新模型的 posterior

- 通过 posterior, 我们使用 acquisition function 求得一个新的超参方案 。不同的 axquisition funciton 能使我们选出的 满足各种需求与假设。

- 将 带入到模型中,计算对应的 , 并将 加入 。这一步也是最耗费时间的一部。

最后,当算法结束时。我们便可以从 中找到我们想要的最优超参

迭代中的相关算法

GP 高斯过程

对于迭代过程中的第一步, 求解 。高斯过程是最常用的,其中 为我们还未计算的超参, 为以观测的超参组及其对应模型分数。

高斯过程由均值函数 与核函数 (kernel function) 决定,例如我们可以选择如下和函数:

我们假设对于任意一个点(一个超参组) , 他的 服从高斯分布

其中

给定 , 当我们预测新的 时,根据 GP 的定义,已知与未知模型分数的联合分布 服从

其中:

因此我们可以得到后验 posterior: 服从分布:

Acquisition Function

如何找到下一个我们将要探索的点,是这整个算法的关键。与强化学习相似,我们希望我们的模型能够权衡 exploration 和 exploitation。

Expected Improvement

EI 的假设是:我们观测到的 并不存在误差项。

EI 的 utility function 取决于我们的 objective function 的优化方向,一般来说,当我们使用 loss 等计算模型评分,此时我们希望 loss 越小越好,则:

其中, ,即我们观测到的 中的模型最低分。

因此

若我们的优化对象为类似 的大而好指标。则:

其中, ,即我们观测到的 中的模型最高分。

因此:

其中 和 分别是 standard Gaussian distribution 的 cumulative distribution function(CDF)和 probability density function(PDF)。

probability of improvement

很经典的算法,但是似乎现在很少用了?

与 EI 相似,Probalitity of Improvement 的 utility function 也是由优化的方向决定,当我们希望模型指标越小越好时:

其中, ,即我们观测到的 中的模型最低分。

因此

Entropy Search

类似于 decision tree 的 partition criteria,我们选择能提供做多信息的那个变量。

其中 utility function 为:

Gaussian Process-Upper Confidence Bound :

其中 用于平衡 exploration 和 exploitation。可以理解为 的权重越大,UCB 则越倾向于 exploration。

"公式里面 的值是根据理论分析推出来的,随时间递增;可是在实际应用里面,好多人为了简便直接把 设成一个常数,也是可以的。" 引用观点

参考

https://zhuanlan.zhihu.com/p/76269142

https://www.cnblogs.com/marsggbo/p/9866764.html

https://zhuanlan.zhihu.com/p/72403538

https://zhuanlan.zhihu.com/p/73832253

https://blog.csdn.net/weixin_41503009/article/details/107679561

https://blog.csdn.net/lj6052317/article/details/78772494/