概述

语义相似度匹配大致分为孪生网络模型和交互式模型。孪生网络模型主要思路在于先分别获得两个句子的表征,而后通过其他距离指标判断句子的语义相似度。部分学者也将 孪生网络 称为 双塔模型 、 “暹罗”架构 等等。而交互式模型则是将两个不同的句子的中间编码进行交互,直接通过深度学习模型计算出相似度,而非采用距离指标进行判断。

该任务下,常见的数据集有 STS、SICK 等。

语义相似度匹配大致分为孪生网络模型和交互式模型。孪生网络模型主要思路在于先分别获得两个句子的表征,而后通过其他距离指标判断句子的语义相似度。部分学者也将 孪生网络 称为 双塔模型 、 “暹罗”架构 等等。而交互式模型则是将两个不同的句子的中间编码进行交互,直接通过深度学习模型计算出相似度,而非采用距离指标进行判断。

该任务下,常见的数据集有 STS、SICK 等。

主要参考了 BERT 蒸馏完全指南|原理/技巧/代码 一文,其中对部分论文的笔记有些抽象,因此遍对提及的蒸馏论文进行了阅读与笔记补充总结。同时总结了 textbrewer 相关使用说明。先来对所有介绍到的模型做个总结:

Distilled BiLSTM - 将 BERT LARGE 蒸馏到了 BiLSTM 上,采用 MST 目标函数与数据增强。 BERT-PKD - 不同于前者,BERT-PKD 加入了对中间层

[CLS]位置上隐状态的拟合。 DistilBERT - 在预训练阶段进行蒸馏,6 层保留了 97% BERT 的表现 TinyBERT - 结合预训练蒸馏与微调蒸馏,提出注意力矩阵蒸馏。速度 x9.4 的 4 层 BERT 达到 96.8%BERT 效果。 MobileBERT - 保持层数,使用 bottlenect 减少维度。速度 x5.5,各种任务上与 BERT 相差约 1%。 MINILM - 提出 Value-Relation Transfer 与助教机制。同样参数数量下,效果由于 TinyBERT,DistillBERT。TextBrewer - 实用的蒸馏框架。

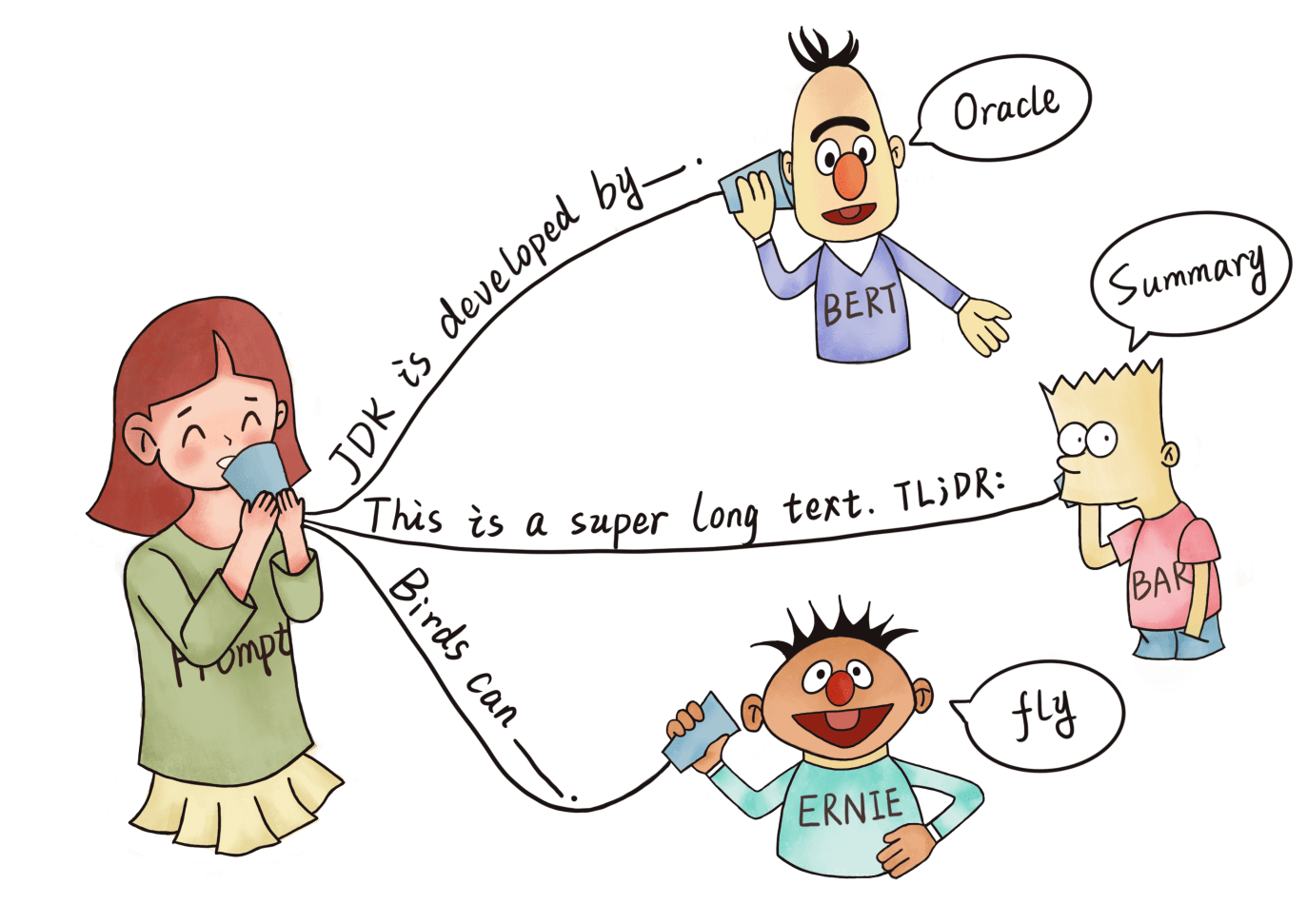

本文总结了 Prompt Tuning(The Power of Scale for Parameter-Efficient Prompt Tuning)、UDG (Towards Zero-Label Language Learning) 读论文总是枯燥且难熬呢,于是便尝试在阅读时便对论文进行了知识点的梳理与记录,有助于加深理解与记忆。希望这份笔记也能提供一些小小的帮助

论文:The Power of Scale for Parameter-Efficient Prompt Tuning

《Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing》 这篇 prompt 综述中,详细地对 NLP 进展与目前 prompt 的作品进行了充分的分析与总结。同时作者在 github 上 对 prompt 论文进行了总结。Prompt 这个系列将根据这些 prompt paper 进行笔记总结与梳理。

本文中将包括 PET, Prefix-Tuning, P-Tuning 三个模型对应的论文笔记。

读论文总是枯燥且难熬呢,于是便尝试在阅读时便对论文进行了知识点的梳理与记录,希望有助于加深理解与记忆。希望这份笔记也能提供一些小小的帮助

本文总结的模型为 CompGCN(Composition-Based Multi-Relational Graph Convolutional Networks)、KGNN (Knowledge-aware Graph Neural Networks with Label Smoothness Regularization for Recommender Systems)

读论文总是枯燥且难熬呢,于是便尝试在阅读时便对论文进行了知识点的梳理与记录,希望有助于加深理解与记忆。希望这份笔记也能提供一些小小的帮助

本文总结的模型为 NRI(Neural Relational Inference for Interacting Systems)、RGCN(Modeling Relational Data with Graph Convolutional Networks)。

几何模型 (geometric models) 研究已经在图像处理、流形学习、信号处理等领域得到了广泛的关注。最近几年也有不少的基于 非欧几里德结构数据 深度学习研究。本文主要对 Monet、EGCN、GraphSage 等模型进行总结。

刚开始接触知识抽取部分的内容,在阅读 《Entity Linking with a Knowledge Base: Issues, Techniques, and Solutions》后对部分实体链接的框架和内容进行了梳理。

该论文从实体链接的角度出发,介绍了部分应用场景,并针对实体链接的不同计算流程总结了学者们的研究成果(2015 年前)。个人认为该文章对与刚入门知识抽取,想要构建整个任务大致框架的读者有很好的帮助。

原文链接:Entity Linking with a Knowledge Base: Issues, Techniques, and Solutions